-

以用户画像解决方案为例:

常见用户画像解决方案的问题

1缺乏完整的标签体系

2无法应对大数据量情况下标签计算

3无法在企业数仓和画像解耦

4没有统一标签管理界面问题

5无法在标签管理整合标签调度任务

6代码缺乏重构,重复代码冗余复杂

7代码东拼西凑、臃肿不堪

黑马用户画像解决方案的优点

1多行业多场景用户画像标签体系构建

2Spark框架处理PB级数据量标签计算解决方案

3机器学习场景下的挖掘类标签构建方案

4海量标签存储和调度方案

5独立画像数据接入平台方案

6大规模数据集下标签任务提交相关资源分配方案

7统一完整的标签管理平台方案

8重构项目代码,专注于核心业务开发

-

以ETL解决方案为例:

常见ETL方案的问题

1单一工具ETL数据抽取

2缺乏元数据管理,溯源体系

3缺乏ETL过程监控

4缺乏数据模型映射

5状态耦合,无法并行运行

6解决方案零碎且不完善

黑马ETL解决方案的优点

1独立研发Python ETL工具

2具备完整的元数据管理体系

3海量数据ETL全流程监控管理

4完备的代码构建数据模型映射

5无状态多进程并行执行,提高执行效率

6完整企业级大规模数据ETL解决方案

-

以数据仓库解决方案为例:

常见数据仓库方案的问题

1缺乏完整的流程涵盖

2无法支撑海量数据

3建模不清晰逻辑混乱

4历史快照的存储过大或查询复杂性能低

5对于增量过程缺少针对性优化方案

6异构数据源间无法关联分析、即席查询

7缺乏重构,表/字段/代码重复冗余复杂

黑马数据仓库解决方案的优点

1包含了需求分析、设计转换、研发优化、脚本调度到部署维护整套方案

2针对海量数据的问题有一系列的优化方案

3数仓分层和数仓建模规则清晰统一

4历史快照存储小查询快性能高

5对增量过程有针对性的优化措施

6解决了异构数据源间的关联分析、即席查询问题

7重构项目代码,专注于核心业务开发

-

以推荐系统解决方案为例:

常见推荐系统方案的问题

1普通单机版推荐系统,无法应对大规模用户推荐场景

2缺乏多商品召回

3缺乏推荐系统精排阶段

4无法应对实时推荐

5缺乏人工规则过滤场景

6没有实现用户画像平台和推荐系统平台对接

黑马推荐系统解决方案的优点

1PB级数据量场景下推荐系统解决方案

2拥有多路召回源,形成多样化的商品列表

3机器学习+深度学习的精排方案,准确为用户推荐商品

4大型分布式应用海量用户的实时推荐

5完备的人工过滤规则,更好的达到推荐效果

6用户画像平台作为推荐系统平台数据接入,实现更加个性化推荐

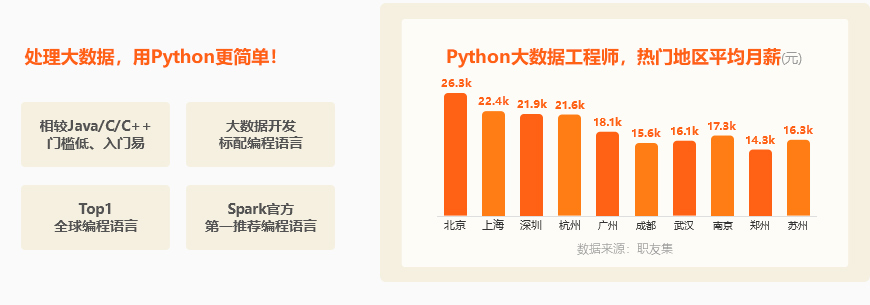

Python+大数据开发 0基础登录IT「薪」赛道

为什么学大数据?

抢占大数据红利

从Python入局0基础起点

学习+就业全规划

从入门到就业 打造实力派数据工程师

课程与时俱进,不断融入热门技术

-

大数据开发入门1

Linux 基本命令用户管理VI权限管理网络管理SSH

MySQL DDLDMLDQL多表查询分组查询约束

Kettle 数据转换脚本组件Job开发

BI工具 基本操作常用图表仪表板

阶段案例实战

* 传统数据仓库实战

-

大数据核心基础2

Zookeeper 架构原理存储模型ZK集群搭建选举机制

Hadoop HDFS HDFS架构Block块存储读写流程NameNodeDataNode高可用集群

Hadoop MapReduce 核心原理执行流程Shuffle机制

Hadoop YARN YARN组件架构原理执行流程调度器

Hive HQL数据类型分区分桶拉链表元数据数据压缩存储格式原理架构性能优化

阶段案例实战

* 社交APP案例实战 -

千亿级数仓技术3

CDH CM架构组件构建CM实操

基于阿里数仓分层架构 ODSDIMDWSDWDDMADS

Hive + Presto 架构原理SQL调优集群构建

Hive 性能调优 数据倾斜JOIN调优HIVE索引

调度 DSAzkabanOozie

阶段项目实战

* 在线教育大数据数仓 * 新零售大数据数仓

-

PB级内存计算4

Python编程 基本语法数据结构函数面向对象异常处理模块与包网络编程多进程多线程闭包装饰器迭代器

Spark 架构原理Spark RDDSpark DFSpark DAGSpark SQL内存迭代性能调优任务调度Pandas on SparkSpark on HiveSpark ShuffleSpark 3.x 新特性

阶段项目实战

* 工业项目实战 * 保险大数据实战

-

亚秒级实时计算5

Flink Core 架构原理批流一体Window操作State操作DataStreamCheckpointFlink SQL任务调度负载均衡状态管理Runtime执行计划Flink性能监控与调优Flink + ElasticsearchFlink + KafkaFlink + PulsarFlink + ClickHouseFlink + Doris

阶段项目实战

* 车联网项目实战 * 金融证券项目实战

-

大厂面试6

数据结构 栈树图数组链表哈希表

高频算法 排序查找数组字符串链表栈队列二叉树回溯动态规划贪心复杂度

面试真题 编程语言SQLHadoop生态HiveSparkFlink

大厂架构 美团点评数仓架构小米大数据架构平安大数据架构

不同起点学生 学后各有收获

- 0基础急速提升

- 应届生入行、长线发展

- 转岗快速上手

- 初级工程师跳槽 / 升职

渐进式课程内容 助你从小白蜕变为数字精英

Python+大数据开发课程大纲

Python编程基础

Python编程进阶

SQL基础

ETL实战

Hadoop技术栈

千亿级离线数仓项目

千亿级离线数仓项目实战

Spark技术栈

用户画像解决方案

PB级内存计算项目实战

就业指导&就业加强

Flink技术栈

亚秒级实时计算项目

查看详细课程大纲>Python编程基础课时:8天

主要内容

主要内容

· Python基础语法· Python数据处理· 函数· 文件读写· 异常处理· 模块和包

可解决的现实问题

可解决的现实问题

熟练掌握Python语言,建立编程思维,使学员能够熟练使用Python技术完成程序编写。

可掌握的核心能力

可掌握的核心能力

1.掌握Python开发环境基本配置;

2.掌握运算符、表达式、流程控制语句、数组等的使用;

3.掌握字符串的基本操作;

4.初步建立面向对象的编程思维;

5.熟悉异常捕获的基本流程及使用方式;

6.掌握类和对象的基本使用方式。

查看详细课程大纲>Python编程进阶课时:8天

主要内容

主要内容

· 面向对象· 网络编程· 多任务编程· 高级语法· Python编程综合项目

可解决的现实问题

可解决的现实问题

熟练使用Python面向对象程序设计思想,掌握数据开发必备Python高级语法,解决常见Python开发问题。

可掌握的核心能力

可掌握的核心能力

1.掌握网络编程技术,能够实现网络通讯;

2.知道通讯协议原理;

3.掌握开发中的多任务编程实现方式;

4. 知道多进程多线程的原理。

查看详细课程大纲>SQL基础课时:4天

主要内容

主要内容

· MySQL与SQL· Kettle与BI工具· Pymysql

可解决的现实问题

可解决的现实问题

熟练掌握MySQL\SQL、Kettle以及BI工具使用,能够解决传统数仓业务开发任务。

可掌握的核心能力

可掌握的核心能力

1. 掌握MySQL数据库的使用;

2. 掌握SQL语法;

3. 掌握Kettle数据迁移工具的使用;

4. 熟练使用BI可视化工具;

5. 对数据开发有一定认知,掌握BI工程师所具备的基本技能。

查看详细课程大纲>ETL实战课时:6天

主要内容

主要内容

· ETL概念与工具· Python ETL实战· BI

可解决的现实问题

可解决的现实问题

掌握Python完成数据ETL实战,能够解决中小型数据量数据处理相关任务。

可掌握的核心能力

可掌握的核心能力

1. 掌握ETL的相关概念;

2. 掌握基于Python语言完成ETL任务开发实战;

3. 基于ETL实战锻炼Python编程能力,包括(元数据管理、数据模型、项目配置、单元测试、工具方法抽取等);

4. 掌握BI数据分析实战。

查看详细课程大纲>Hadoop技术栈课时:11天

主要内容

主要内容

· Linux· 大数据基础和硬件介绍· Zookeeper· HDFS· MapReduce· YARN· Hive基础· Hive高阶

可解决的现实问题

可解决的现实问题

熟悉Linux操作系统,以及各种Linux命令,能够解决企业级大数据集群搭建问题,为进阶大数据开发奠定基础。

可掌握的核心能力

可掌握的核心能力

1.掌握Linux常用命令,为数据开发后续学习打下的良好基础;

2.掌握大数据的核心框架Hadoop以及其生态体系,完成HDFS、MapReduce及Yarn机制基本理解与使用;能顾搭建Hadoop高可用HA集群;

3.掌握Hive的使用和调优;

4.具备Hadoop开发能力、离线数据仓库开发能力;

5.能够完成基本构建企业级数仓。

查看详细课程大纲>千亿级离线数仓项目课时:11天

主要内容

主要内容

· 大数据部署运维:Cloudera Manager· 分析决策需求:数据仓库· 数据采集:sqoop· 数据分析:Hive· 历史数据快照:拉链表· 数据更新后的统计分析:拉链表· 数据调度:oozie+shell· OLAP系统存储:MySQL· FineBI数据展示

可解决的现实问题

可解决的现实问题

能够解决企业级常见数据仓库搭建,从项目的需求、技术架构、业务架构、部署平台、ETL设计、作业调度等整套pipeline,完成大数据体系下的企业级数据仓库构建。

可掌握的核心能力

可掌握的核心能力

1.掌握零售行业离线数仓的分层与建模,从需求、设计、研发、测试到落地上线的完整项目流程;

2.行业内首个深度使用Presto的项目;

3.包括海量数据场景下如何优化配置;

4.拉链表的具体应用;

5.新增数据和更新数据的抽取和分析;

6.提供新零售大型商超集团的数据存储分析以及服务监控方案。

查看详细课程大纲>千亿级离线数仓项目实战课时:5天

主要内容

主要内容

· 大数据部署运维:Cloudera Manager· 分析决策需求:数据仓库· 数据采集:sqoop· 数据分析:Hive+presto· 历史数据快照:拉链表· 数据更新后的统计分析:拉链表· 数据调度:ds· OLAP系统存储:MySQL· FineBI数据展示

可解决的现实问题

可解决的现实问题

按照企业级大数据开发流程,独立完成项目开发,掌握企业级多场景大数据离线数仓开发能力,从数仓分层,数仓建模,指标统计,指标展示完成完整的大数据项目。

可掌握的核心能力

可掌握的核心能力

1.掌握教育行业离线数仓的分层与建模,从需求、设计、研发、测试到落地上线的完整项目流程;

2.真实业务逻辑,共涉及20多个主题,100多个指标,提升学员在教育行业中的核心竞争力;

3.包括海量数据场景下如何优化配置;

4.拉链表的具体应用;

5.新增数据和更新数据的抽取和分析;

6.Hive函数的具体应用;

7.ClouderaManager可视化、自动部署和配置、Git、CodeReview功能。

查看详细课程大纲>Spark技术栈课时:10天

主要内容

主要内容

· Pandas基础· Pandas数据处理实战· Spark基础· Spark Core· Spark SQL· SparkSQL案例· Kafka· Elasticsearch

可解决的现实问题

可解决的现实问题

掌握全球热门的Spark技术栈,通过SparkCore和SparkSQL解决数据处理与统计分析工作,进阶高级大数据开发工程师。

可掌握的核心能力

可掌握的核心能力

1.掌握Spark的RDD、DAG、CheckPoint等设计思想;

2.掌握SparkSQL结构化数据处理,Spark On Hive;

3.掌握Structured Streaming整合多数据源完成实时数据处理;

4.具备Spark全栈开发能力,满足大数据行业多场景统一技术栈的数据开发,提供就业核心竞争力。

查看详细课程大纲>用户画像解决方案课时:8天

主要内容

主要内容

· 1SparkSQL整合ES自定义数据源· DS任务界面化调度· 用户画像标签构建规则· 用户画像规则类标签构建· 用户画像统计类标签构建

可解决的现实问题

可解决的现实问题

项目提供了全行业用户画像解决方案, 使用SparkSQL+ES+DS构建企业级用户画像,通过SparkSQL+MySQL构建通用行业用户画像标签体系。

可掌握的核心能力

可掌握的核心能力

1. SparkSQL整合ES自定义数据源;

2. DS任务界面化调度;

3. 用户画像标签构建规则;

4. 用户画像规则类标签构建;

5. 用户画像统计类标签构建。

查看详细课程大纲>PB级内存计算项目实战课时:5天

主要内容

主要内容

项目核心架构和业务流程、Hive数仓建模 、Sqoop数据同步开发 DolphinScheduler任务调度、使用lag,sum等窗口函数 、使用UDAF函数计算有效保单数字段、计算现金价值、计算和准备金、分区表的使用 、指标汇总计算 、Shuffle优化。

可解决的现实问题

可解决的现实问题

基于Spark全栈技术构建企业级大数据开发平台,学生分组独立完成项目实战,能够胜任常见大数据平台开发工作,助力企业实现数字化转型

可掌握的核心能力

可掌握的核心能力

1.快速搭建保险行业大数据平台;

2.基于Hive+Spark SQL搭建离线数据仓库;

3.基于SparkSQL应对轻松应对复杂的迭代计算;

4.完成基于国内头部保险公司大数据项目开发;

5.掌握基于Spark分析12亿报单表和8千万客户等数据;

6.对保单汇总计算(业务发展类指标,成本费用类指标等),并向业务人员做数据展示。

查看详细课程大纲>就业指导&就业加强课时:5天

主要内容

主要内容

· SQL实战· Hive数据分析与面试题加强· Spark数据分析与面试题加强· NoSQL数据分析与面试题加强· 大数据多行业架构剖析

可解决的现实问题

可解决的现实问题

对学习的内容进行整体回顾,并分析经典面试题,指导简历,面试和沟通技巧助力高薪offer。

可掌握的核心能力

可掌握的核心能力

1.强化面试就业核心面试题;

2.梳理大数据架构及解决方案;

3.剖析多行业大数据架构。

查看详细课程大纲>Flink技术栈课时:6天

主要内容

主要内容

· Flink Core· Flink DataStream· Flink SQL· Flink Runtime· Flink高级· Flink电商案例实战

可解决的现实问题

可解决的现实问题

掌握当下热门的流批一体化分布式计算框架Flink及其生态,解决实时计算经典场景问题,适应市场对Flink越发增长的需求。

可掌握的核心能力

可掌握的核心能力

1.掌握基于Flink进行实时和离线数据处理、分析;

2.掌握基于Flink的多流并行处理技术;

3.掌握千万级高速实时采集技术。

查看详细课程大纲>亚秒级实时计算项目课时:8天

主要内容

主要内容

· Flink· FlinkSQL· FlinkCDC· Doris· Hudi· Hudi on Hive FIneBI

可解决的现实问题

可解决的现实问题

采集超过千万条在线视频的数据,实时高性能海量数据分析与存储业务数据实时大屏场景实现。

可掌握的核心能力

可掌握的核心能力

1.湖仓一体化解决方案基于Flink+Hudi湖仓一体技术架构;

2.基于FlinkCDC完成MySQL等数据源的数据采集;

3.FlinkSQL流批一体架构实现实时数据计算;

4.使用Apache Doris进行海量多维分析;

5.掌握数据报表分析;

6.掌握业务数据实时大屏场景实现。

Python编程基础

Python编程进阶

SQL基础

ETL实战

Hadoop技术栈

千亿级离线数仓项目

千亿级离线数仓项目实战

Spark技术栈

用户画像解决方案

PB级内存计算项目实战

就业指导&就业加强

Flink技术栈

亚秒级实时计算项目

查看详细课程大纲>Python编程基础课时:8天

主要内容

主要内容

· Python基础语法· Python数据处理· 函数· 文件读写· 异常处理· 模块和包

可解决的现实问题

可解决的现实问题

熟练掌握Python语言,建立编程思维,使学员能够熟练使用Python技术完成程序编写。

可掌握的核心能力

可掌握的核心能力

1.掌握Python开发环境基本配置;

2.掌握运算符、表达式、流程控制语句、数组等的使用;

3.掌握字符串的基本操作;

4.初步建立面向对象的编程思维;

5.熟悉异常捕获的基本流程及使用方式;

6.掌握类和对象的基本使用方式。

查看详细课程大纲>Python编程进阶课时:8天

主要内容

主要内容

· 面向对象· 网络编程· 多任务编程· 高级语法· Python编程综合项目

可解决的现实问题

可解决的现实问题

熟练使用Python面向对象程序设计思想,掌握数据开发必备Python高级语法,解决常见Python开发问题。

可掌握的核心能力

可掌握的核心能力

1.掌握网络编程技术,能够实现网络通讯;

2.知道通讯协议原理;

3.掌握开发中的多任务编程实现方式;

4. 知道多进程多线程的原理。

查看详细课程大纲>SQL基础课时:4天

主要内容

主要内容

· MySQL与SQL· Kettle与BI工具· Pymysql

可解决的现实问题

可解决的现实问题

熟练掌握MySQL\SQL、Kettle以及BI工具使用,能够解决传统数仓业务开发任务。

可掌握的核心能力

可掌握的核心能力

1. 掌握MySQL数据库的使用;

2. 掌握SQL语法;

3. 掌握Kettle数据迁移工具的使用;

4. 熟练使用BI可视化工具;

5. 对数据开发有一定认知,掌握BI工程师所具备的基本技能。

查看详细课程大纲>ETL实战课时:6天

主要内容

主要内容

· ETL概念与工具· Python ETL实战· BI

可解决的现实问题

可解决的现实问题

掌握Python完成数据ETL实战,能够解决中小型数据量数据处理相关任务。

可掌握的核心能力

可掌握的核心能力

1. 掌握ETL的相关概念;

2. 掌握基于Python语言完成ETL任务开发实战;

3. 基于ETL实战锻炼Python编程能力,包括(元数据管理、数据模型、项目配置、单元测试、工具方法抽取等);

4. 掌握BI数据分析实战。

查看详细课程大纲>Hadoop技术栈课时:11天

主要内容

主要内容

· Linux· 大数据基础和硬件介绍· Zookeeper· HDFS· MapReduce· YARN· Hive基础· Hive高阶

可解决的现实问题

可解决的现实问题

熟悉Linux操作系统,以及各种Linux命令,能够解决企业级大数据集群搭建问题,为进阶大数据开发奠定基础。

可掌握的核心能力

可掌握的核心能力

1.掌握Linux常用命令,为数据开发后续学习打下的良好基础;

2.掌握大数据的核心框架Hadoop以及其生态体系,完成HDFS、MapReduce及Yarn机制基本理解与使用;能顾搭建Hadoop高可用HA集群;

3.掌握Hive的使用和调优;

4.具备Hadoop开发能力、离线数据仓库开发能力;

5.能够完成基本构建企业级数仓。

查看详细课程大纲>千亿级离线数仓项目课时:11天

主要内容

主要内容

· 大数据部署运维:Cloudera Manager· 分析决策需求:数据仓库· 数据采集:sqoop· 数据分析:Hive· 历史数据快照:拉链表· 数据更新后的统计分析:拉链表· 数据调度:oozie+shell· OLAP系统存储:MySQL· FineBI数据展示

可解决的现实问题

可解决的现实问题

能够解决企业级常见数据仓库搭建,从项目的需求、技术架构、业务架构、部署平台、ETL设计、作业调度等整套pipeline,完成大数据体系下的企业级数据仓库构建。

可掌握的核心能力

可掌握的核心能力

1.掌握零售行业离线数仓的分层与建模,从需求、设计、研发、测试到落地上线的完整项目流程;

2.行业内首个深度使用Presto的项目;

3.包括海量数据场景下如何优化配置;

4.拉链表的具体应用;

5.新增数据和更新数据的抽取和分析;

6.提供新零售大型商超集团的数据存储分析以及服务监控方案。

查看详细课程大纲>千亿级离线数仓项目实战课时:5天

主要内容

主要内容

· 大数据部署运维:Cloudera Manager· 分析决策需求:数据仓库· 数据采集:sqoop· 数据分析:Hive+presto· 历史数据快照:拉链表· 数据更新后的统计分析:拉链表· 数据调度:ds· OLAP系统存储:MySQL· FineBI数据展示

可解决的现实问题

可解决的现实问题

按照企业级大数据开发流程,独立完成项目开发,掌握企业级多场景大数据离线数仓开发能力,从数仓分层,数仓建模,指标统计,指标展示完成完整的大数据项目。

可掌握的核心能力

可掌握的核心能力

1.掌握教育行业离线数仓的分层与建模,从需求、设计、研发、测试到落地上线的完整项目流程;

2.真实业务逻辑,共涉及20多个主题,100多个指标,提升学员在教育行业中的核心竞争力;

3.包括海量数据场景下如何优化配置;

4.拉链表的具体应用;

5.新增数据和更新数据的抽取和分析;

6.Hive函数的具体应用;

7.ClouderaManager可视化、自动部署和配置、Git、CodeReview功能。

查看详细课程大纲>Spark技术栈课时:10天

主要内容

主要内容

· Pandas基础· Pandas数据处理实战· Spark基础· Spark Core· Spark SQL· SparkSQL案例· Kafka· Elasticsearch

可解决的现实问题

可解决的现实问题

掌握全球热门的Spark技术栈,通过SparkCore和SparkSQL解决数据处理与统计分析工作,进阶高级大数据开发工程师。

可掌握的核心能力

可掌握的核心能力

1.掌握Spark的RDD、DAG、CheckPoint等设计思想;

2.掌握SparkSQL结构化数据处理,Spark On Hive;

3.掌握Structured Streaming整合多数据源完成实时数据处理;

4.具备Spark全栈开发能力,满足大数据行业多场景统一技术栈的数据开发,提供就业核心竞争力。

查看详细课程大纲>用户画像解决方案课时:8天

主要内容

主要内容

· 1SparkSQL整合ES自定义数据源· DS任务界面化调度· 用户画像标签构建规则· 用户画像规则类标签构建· 用户画像统计类标签构建

可解决的现实问题

可解决的现实问题

项目提供了全行业用户画像解决方案, 使用SparkSQL+ES+DS构建企业级用户画像,通过SparkSQL+MySQL构建通用行业用户画像标签体系。

可掌握的核心能力

可掌握的核心能力

1. SparkSQL整合ES自定义数据源;

2. DS任务界面化调度;

3. 用户画像标签构建规则;

4. 用户画像规则类标签构建;

5. 用户画像统计类标签构建。

查看详细课程大纲>PB级内存计算项目实战课时:5天

主要内容

主要内容

项目核心架构和业务流程、Hive数仓建模 、Sqoop数据同步开发 DolphinScheduler任务调度、使用lag,sum等窗口函数 、使用UDAF函数计算有效保单数字段、计算现金价值、计算和准备金、分区表的使用 、指标汇总计算 、Shuffle优化。

可解决的现实问题

可解决的现实问题

基于Spark全栈技术构建企业级大数据开发平台,学生分组独立完成项目实战,能够胜任常见大数据平台开发工作,助力企业实现数字化转型

可掌握的核心能力

可掌握的核心能力

1.快速搭建保险行业大数据平台;

2.基于Hive+Spark SQL搭建离线数据仓库;

3.基于SparkSQL应对轻松应对复杂的迭代计算;

4.完成基于国内头部保险公司大数据项目开发;

5.掌握基于Spark分析12亿报单表和8千万客户等数据;

6.对保单汇总计算(业务发展类指标,成本费用类指标等),并向业务人员做数据展示。

查看详细课程大纲>就业指导&就业加强课时:5天

主要内容

主要内容

· SQL实战· Hive数据分析与面试题加强· Spark数据分析与面试题加强· NoSQL数据分析与面试题加强· 大数据多行业架构剖析

可解决的现实问题

可解决的现实问题

对学习的内容进行整体回顾,并分析经典面试题,指导简历,面试和沟通技巧助力高薪offer。

可掌握的核心能力

可掌握的核心能力

1.强化面试就业核心面试题;

2.梳理大数据架构及解决方案;

3.剖析多行业大数据架构。

查看详细课程大纲>Flink技术栈课时:6天

主要内容

主要内容

· Flink Core· Flink DataStream· Flink SQL· Flink Runtime· Flink高级· Flink电商案例实战

可解决的现实问题

可解决的现实问题

掌握当下热门的流批一体化分布式计算框架Flink及其生态,解决实时计算经典场景问题,适应市场对Flink越发增长的需求。

可掌握的核心能力

可掌握的核心能力

1.掌握基于Flink进行实时和离线数据处理、分析;

2.掌握基于Flink的多流并行处理技术;

3.掌握千万级高速实时采集技术。

查看详细课程大纲>亚秒级实时计算项目课时:8天

主要内容

主要内容

· Flink· FlinkSQL· FlinkCDC· Doris· Hudi· Hudi on Hive FIneBI

可解决的现实问题

可解决的现实问题

采集超过千万条在线视频的数据,实时高性能海量数据分析与存储业务数据实时大屏场景实现。

可掌握的核心能力

可掌握的核心能力

1.湖仓一体化解决方案基于Flink+Hudi湖仓一体技术架构;

2.基于FlinkCDC完成MySQL等数据源的数据采集;

3.FlinkSQL流批一体架构实现实时数据计算;

4.使用Apache Doris进行海量多维分析;

5.掌握数据报表分析;

6.掌握业务数据实时大屏场景实现。

项目驱动式教学 还原真实职场氛围

锻炼学生实战能力,入职即能快速上手

依托于大型项目库14大行业、16个“大厂级”项目、

400+业务指标 220+技术点、真实业务数据

高标准企业级开发流程

全流程项目实战项目启动>团队需求分析>实战方案设计

> 小组PK>项目汇报答辩>复盘

- 新零售离线数仓

- 电商用户画像

- 在线教育湖仓一体

- 车联网实时数仓

- 金融保险离线数仓

-

项目介绍:该项目基于国内大型新零售巨头开发的大数据平台,基于高性能解决方案构建离线数仓,包括销售、会员、商品等主题,每个主题涵盖大量真实的业务场景。项目采用Hive+Presto架构构建高性能的离线处理方案,包括CM自动部署与配置、数据仓库建模、数仓架构分层、Hive的使用和调优、Presto使用与调优、拉链表历史快照、更新数据的增量计算、Python-ETL自研系统、主流ETL开源系统、Shell脚本、Python脚本、Dolphinscheduler调度、全量增量完整流程实现等。

核心解决方案:数据仓库分层设计方案、数据仓库建模方案、异构数据源间的关联分析、即席查询解决方案、历史快照的存储、更新和查询方案、增量数据的优化方案

进入项目体验300+指标数量1000万数据量20个解决方案10天课程天数

-

项目介绍:该项目基于垂直电商平台构建的用户全方位画像,完整抽取出一个用户的信息全貌业务围绕商品、订单、用户基础信息及行为信息等数据,实现用户和商品基础标签、组合标签、微观画像、标签查询等业务场景,提供了企业级多方位业务决策分析。标签体系中包涵了基础类标签,规则类标签,挖掘类标签及组合类标签,为企业数据决策及推荐系统提供支持。项目拥有完备的标签管理平台,数据接入平台,标签计算平台和调度平台等。

核心解决方案:用户分群画像解决方案、Lambda架构流批方案、Spark+ES+Hadoop生态圈技术栈

进入项目体验200个指标数量3000万数据量10个解决方案9天课程天数

-

项目介绍:湖仓一体化项目基于在线教育行业实时数据处理和分析。项目采用流处理计算引擎Flink,实时处理千万数据量的视频流数据,基于FlinkCDC完成MySQL等数据源的数据采集,通过Hudi On Hive构建湖仓一体架构,结合数据湖和数据仓库优势,建立湖仓一体化,进而解决了数据湖的局限性。直接在用于数据湖的低成本存储上实现与数据仓库中类似的数据结构和数据管理功能。项目采用Hive实现离线数据计算,采用FlinkSQL实现实时数据计算,使用流行OLAP的Doris进行海量多维分析,最终实现在在线教育行业实时分析指标体系构建。

核心解决方案:数据仓库运维方案、数据仓库建模方案、历史快照的存储、更新和查询方案、增量数据的优化方案

进入项目体验110个指标数量1500万数据量15个解决方案8天课程天数

-

项目介绍:车联网项目涵盖完整车联网业务场景,包含驾驶行程、电子围栏、远程诊断等真实业务,通过 QBOX 车辆终端数据收集,并解析为 QSP 数据、QCS 数据、充电数据、HU 数据,提供实时计算服务与离线计算服务,并通过 API 接口以报表和大屏展示分析结果数据。

核心解决方案:车辆网行业解决方案、Flink+Kafka实时数仓(ODS/DWD/DWS/ADS)、CK(Clickhouse)即席查询

进入项目体验161个指标数量1800万/15分钟数据量15个解决方案8天课程天数

-

项目介绍:保险精算项目需要计算海量明细保单数据,以便生成财务报表。项目使用SparkSQL来计算,时效变快,增强保险公司的商业信誉。项目将多部门的业务数据库同步到hive数据集市,使用SparkSQL加载源数据表(保单表12亿保单,客户表8千万客户等),计算保单的保费、现金价值、准备金等明细,提供给财务部门收费或支出,对保单汇总计算(业务发展类指标,成本费用类指标等),并向业务人员做数据展示。

核心解决方案:保险项目核心解决方案、SparkSQL一站式解决迭代计算、基于SparkSQL的离线数仓分层(ODS/DW/APP)

进入项目体验120个指标数量10亿数据量10个解决方案8天课程天数

开发不必从零开始 解决方案拿来即用

大厂教研师资团队 全程陪伴带你乘风破浪

引进京东、百度、小米、搜狐、360、途牛、平安、德邦、上交所等大厂背景师资,更有多位Apache社区源码贡献者随堂授课

-

张老师Apache Flink源码贡献者

擅长实时计算领域 -

赵老师985计算机硕士

擅长大数据/人工智能技术方向 -

李老师985计算机硕士

Apache Doris社区贡献者 -

曹老师Apache Flink源码贡献者

擅长大数据云平台技术领域 -

赵老师Apache Pulsar社区贡献者

擅长数仓领域 -

康老师985硕士

擅长数据库与数据挖掘技术领域 -

原老师北京大学计算机硕士

擅长大数据/人工智能领域技术 -

孔老师Apache DolphinScheduler社区贡献者

擅长离线数仓领域 -

朱老师985计算机硕士

擅长大数据/人工智能方向

百万级课程环境配置 大规模真数据体验

学习大数据,你见过真的海量数据吗?你操作过真的【大规模集群】吗?你接触过真的【云服务】吗?这一切,在黑马程序员都将实现真接触!

黑马程序员与知名云平台厂商—UCloud达成深度合作。为学生提供大规模服务器

集群进行实战,硬件规模达到:

真正让每个学生都能接触【真·大规模集群】和【真·大规模数据】

Python+大数据开发 免费教程资源分享

Python+大数据课程体系V3.0

聚集多位Apache 社区贡献者及大厂技术讲师,联合推出行业重磅Python大数据V3.0课程,通过5-6个月学习进阶数据开发工程师,获取3-4年开发经验,对标高级数据开发工程师

Python+大数据V3.0学习路线概览

第一阶段第二阶段第三阶段第四阶段第五阶段

Python编程基础 Python编程进阶 SQL基础 项目一 ETL实战 Hadoop技术栈

第六阶段第七阶段第八阶段第九阶段

项目二 千亿级离线数仓项目 项目三 千亿级离线数仓项目实战 Spark技术栈 项目四 用户画像解决方案

第十阶段第十一阶段第十二阶段第十三阶段第十四阶段

升级V3.0课程亮点:

- 六项目制,40+天项目占比对标企业实际招聘需求,采用六个不同行业大数据项目,覆盖从离线到实时计算场景,更好的匹配学员能力

- 大厂级技术解决方案,Apache贡献者领衔授课课程覆盖了数字化转型企业主流的技术和业务解决方案。

6个技术解决方案:包括ETL、离线数仓、用户画像、Lambda架构、Kappa架构、湖仓一体等;

多个业务解决方案:包括国内大型商超新零售、金融保险、金融证券、物流仓储、航空、电商、出行、教育、物联网等领域

敢以班级为单位公开就业信息的机构,只有传智教育!通过数千班级实施和就业结果显示,传智教育Python+大数据开发的课程,有效大幅提升就业薪资水平!

课程大纲

-

基础班

1. SQL基础

-

高手班

1. Hadoop技术栈 2. 千亿级离线数仓项目 3. 千亿级离线数仓项目实战 4. Python基础编程 5. ETL实战 6. BI报表开发项目实战 7. Spark技术栈 8. 用户画像解决方案 9. PB级内存计算项目实战 10. 基于AI大模型数据开发项目实战 11. 面试加强 12. 阿里云实时计算Flink全栈开发 13. 阿里云实时计算项目

-

进阶班

1. 亚秒级实时进阶课

Python+大数据课程升级版本V4.0

-

SQL基础基础班 1

课时:8天 技术点:50项 测验:1次 学习方式:线下面授

学习目标

1. 掌握MySQL数据库的使用| 2. 掌握SQL语法| 3. 掌握Kettle数据迁移工具的使用| 4. 熟练使用BI可视化工具| 5. 对数据开发有一定认知,掌握BI工程师所具备的基本技能

主讲内容

1. Linux操作系统零基础入门Linux操作系统,掌握Linux基础命令。

计算机基础知识|Linux环境安装|远程连接工具|文件操作命令|压缩解压缩命令|文件查找命令|系统管理命令|权限管理|网络服务管理命令等。

2. MySQL与SQL零基础小白通过MySQL数据库,掌握核心必备SQL。

数据库环境搭建|SQL语言(DDL、DML、DQL)|多表查询|索引等。

3. Kettle与BI工具使用Kettle做数据迁移,通过BI工具展示Excel、MySQL中的数据。

数据仓库与ETL|Kettle安装部署|数据抽取与装载入门|表输入组件|表输出|插入/更新|switch/case等组件使用,开发Kettle作业等。

4. 电商运营指标分析通过Kettle+MySQL+FineBI完成电商运营指标分析。

电商业务背景|案例架构|数据仓库数据增量同步|ETL开发|指标SQL开发|Kettle作业调度|FineBi可视化展示等。

-

Hadoop技术栈高手班 1

课时:11天 技术点:120项 测验:1次 学习方式:线下面授

学习目标

1.掌握Linux常用命令,为数据开发后续学习打下的良好基础| 2.掌握大数据的核心框架Hadoop以及其生态体系,完成HDFS、MapReduce及Yarn机制基本理解与使用;能顾搭建Hadoop高可用HA集群| 3.掌握Hive的使用和调优| 4.具备Hadoop开发能力、离线数据仓库开发能力| 5.能够完成基本构建企业级数仓

主讲内容

1. Linux掌握Linux操作系统常用命令和权限管理,包含了以下技术点:

01_Linux系统安装和体验| 02_Linux系统网络配置和连接工具| 03_Linux系统目录结构| 04_Linux命令使用| 05_Linux命令选项的使用| 06_远程登录和远程拷贝| 07_Linux权限管理| 08_vi编辑器使用| 09_Sed| 10_AWK| 11_权限管理

2. 大数据基础和硬件介绍进一步阐述大数据特点与分布式思想,知识点由浅入深,包含了以下技术点:

01_大数据的特点| 02_分布式存储概念| 03_分布式计算的概念| 04_服务器种类介绍、机架、交换机| 05_网络拓扑、Raid、IDC数据中心| 06_Linux shell编程、awk、sed、cut、ssh、scp、expect、yum、nestat、top 、iostat等高级命令使用

3. Zookeeper分布式软件管家,实现了集群管理与leader选举,包含了以下技术点:

01_Zookeeper的应用场景| 02_架构和原理| 03_存储模型| 04_选举机制| 05_客户端操作

4. HDFS分布式文件系统,解决了海量数据存储与容错,包含了以下技术点:

01_HDFS设计的特点| 02_Master-Slave架构| 03_Block块存储、RF拷贝因子、机架感知| 04_Block拷贝策略、读写流程| 05_HDFS Federation、HDFS Snapshots0、NameNode HA架构和原理| 06_HDFS管理员常用操作、HDFS权限控

5. MapReduce分布式计算系统,解决海量数据的计算,包含了以下技术点:

01_MapReduce架构和原理| 02_Split机制| 03_MapReduce并行度| 04_Combiner机制| 05_Partition机制、自定义Partition| 06_MapReduce序列化、自定义排序、数据压缩

6. YARN分布式资源调度管理器,管理服务器软件资源,包含了以下技术点:

01_Yarn原理和架构| 02_Yarn高可用| 03_Container资源的封装(CPU、内存和IO)| 04_资源调度策略(FIFO、Fair和Capacity)

7. Hive基础数据仓库Hive,实现企业级数仓必备工具,包含以下知识点:

01_HQL操作| 02_数据类型| 03_分区、分桶、临时表| 04_.explain执行计划详解

8. Hive进阶数据仓库Hive高阶原理和架构深入,实现企业级数仓优化,包含以下知识点:

01_Hive原理和架构 02_Meta Store服务 03_HiveServer内置函数 04_自定义UDF和UDAF 05_数据压缩、存储格式、自动化脚本、常见性能优化

-

千亿级离线数仓项目高手班 2

课时:11天技术点:105项测验:0次学习方式:线下面授

学习目标

1.掌握泛电商行业离线数仓的分层与建模,从需求、设计、研发、测试到落地上线的完整项目流程| 2.行业内首个深度讲解数仓建模模型方案的主体项目| 3.包括海量数据场景下如何优化配置| 4.掌握项目迁移能力,能够将项目迁移至泛电商的各个领域| 5.掌握在泛电商行业中关于全量与增量数据处理模式| 6.提供泛电商行业下的数据存储分析以及服务监控方案

本项目基于某泛电商研发的大数据分析平台。项目原型来自于某大型生鲜平台,完全模拟企业真实数仓开发模式,拥有真实的主题化开发;真实的数据结构,复杂的SQL实现过程,学生学习以后可以开发企业级离线数仓的水平。

进入项目体验主讲解决方案

项目介绍与环境准备、数据迁移与数仓分层设计、核心五大主题域开发、基于Fine Report的大屏展示、基于海豚调度的全流程项目上线实施,提供新泛电商大型商超集团的数据存储分析以及服务监控方案。

主讲知识点

1.大数据部署运维:Cloudera Manager| 2.分析决策需求数据仓库:Hive| 3.数据采集:DataX| 4.数据分析:Hive| 5.数据调度:Dolphinscheduler| 6.OLAP系统存储:PostgreSql| 7.Fine Report数据报表与大屏| 8.数仓建模: 范式与维度建模| 9.五大核心主题域开发: 销售域、供应链域、会员域等

-

千亿级离线数仓项目实战高手班 3

课时:5天技术点:40项测验:0次学习方式:线下面授

学习目标

1.掌握教育行业离线数仓的分层与建模,从需求、设计、研发、测试到落地上线的完整项目流程| 2.真实业务逻辑,共涉及20多个主题,100多个指标,提升学员在教育行业中的核心竞争力| 3.包括海量数据场景下如何优化配置| 4.拉链表的具体应用| 5.新增数据和更新数据的抽取和分析| 6.Hive函数的具体应用| 7.ClouderaManager可视化、自动部署和配置、Git、CodeReview功能

受互联网+概念的催化,教育市场发展火热,越来越多的教育机构和平台不断涌现,包括有线上学习和线下培训,K12教育和职业教育等。

进入项目体验主讲解决方案

掌握离线数仓的分层与建模、大数据量场景下如何优化配置,拉链表的具体应用,新增数据的抽取和分析,更新数据的抽取和分析,以及Hive函数的具体应用等。ClouderaManager可视化、自动部署和配置、Git的CodeReview功能保证项目高质量。 离线数仓的分层与建模 项目涉及20多个主题,100多个指标场景 帆软BI企业级报表展示。

主讲知识点

1.大数据部署运维:Cloudera Manager| 2.分析决策需求:数据仓库| 3.数据仓库:Hive| 4.数据采集:sqoop| 5.数据分析:Hive| 6.历史数据快照:拉链表| 7.数据调度:oozie+shell| 8.OLAP系统存储:MySQL| 9.FineBI数据展示

-

Python基础编程高手班 4

课时:8天 技术点:100项 测验:1次 学习方式:线下面授

学习目标

1.掌握Python开发环境基本配置| 2.掌握运算符、表达式、流程控制语句、数组等的使用| 3.掌握字符串的基本操作| 4.初步建立面向对象的编程思维| 5.熟悉异常捕获的基本流程及使用方式| 6.掌握类和对象的基本使用方式| 7.掌握网络编程技术,能够实现网络通讯| 8.知道多进程多线程的原理

主讲内容

1. Python基础语法零基础学习Python的开始,包含了以下技术点:

01_计算机基础知识| 02_认识Python| 03_环境搭建| 04_第一个Python程序| 05_注释| 06_变量| 07_标识符和关键字| 08_输入和输出| 09_运算符| 10_数据类型转换| 11_PEP8编码规范| 12_比较/关系运算符| 13_if判断语句语法格式| 14_三目运算符| 15_while语句语法格式| 16_while 循环嵌套| 17_break 和 continue| 18_while 循环案例| 19_for循环

2. Python数据处理掌握Python的数据类型,并对其进行操作处理,包含了以下技术点:

01_字符串定义语法格式| 02_字符串遍历| 03_下标和切片| 04_字符串常见操作| 05_列表语法格式| 06_列表的遍历| 07_列表常见操作| 08_列表嵌套| 09_列表推导式| 10_元组语法格式| 11_元组操作| 12_字典语法格式| 13_字典常见操作| 14_字典的遍历| 15_集合的操作

3. 函数能够实现Python函数的编写,包含了以下技术点:

01_函数概念和作用、函数定义、调用| 02_函数的参数| 03_函数的返回值| 04_函数的注释| 05_函数的嵌套调用| 06_可变和不可变类型| 07_局部变量| 08_全局变量| 09_组包和拆包、引用

4. 文件读写能够使用Python对文件进行操作,包含了以下技术点:

01_文件的打开与关闭、文件的读写| 02_文件、目录操作及案例| 03_os模块文件与目录相关操作

5. 异常处理主要介绍了在Python编程中如何处理异常,包含了以下技术点:

01_异常概念| 02_异常捕获| 03_自定义异常

6. 模块和包主要介绍了Python中的模块和包的体系,以及如何使用模块和包,包含了以下技术点:

01_模块介绍| 02_模块的导入| 03_包的概念| 04_包的导入| 05_模块中的__all__| 06_模块中__name__| 07_自定义模块| 08_Python中的包

7. Python面向对象从逐步建立起面向对象编程思想,再到会使用对象,到创建对象,再到真正理解为什么封装对象,包含了以下技术点:

01_面向对象介绍| 02_类的定义和对象的创建| 03_添加和获取对象属性| 04_self 参数| 05_init方法| 06_继承| 07_子类方法重写| 08_类属性和实例属性| 09_类方法、实例方法、静态方法

8. Python高级语法主要学习Python的高级语法,包含以下技术点:

01_闭包| 02_装饰器| 03_深浅拷贝| 04_正则

9. Python多任务编程主要学习Python中多线程、多进程,包含了以下技术点:

01_多任务介绍| 02_多进程的使用| 03_多线程的使用| 04_线程同步

10. Python网络编程主要学习通讯协议,以及Python实现TCP、HTTP通讯,包含了以下技术点:

01_IP地址的介绍| 02_端口和端口号的介绍| 03_TCP的介绍| 04_Socket的介绍| 05_TCP网络应用的开发流程| 06_基于TCP通信服务程序开发| 07_必备前端基础知识| 08_HTTP协议与Web服务开发案例

-

ETL实战高手班 5

课时:5天 技术点:48项 测验:0次 学习方式:线下面授

学习目标

1.掌握ETL的相关概念| 2.掌握基于Python语言完成ETL任务开发实战| 3.基于ETL实战锻炼Python编程能力,包括(元数据管理、数据模型、项目配置、单元测试、工具方法抽取等)| 4.掌握BI数据分析实战

主讲内容

1. ETL概念与工具零基础掌握ETL基础概念与常见ETL工具。

01_ETL简介| 02_ETL流程介绍| 03_ETL工具介绍

2. Python ETL实战掌握零售行业ETL项目,完成ETL全流程开发。

01_ETL项目实操| 02_FineBI基础使用| 03_FineBI项目展示

-

BI报表开发项目实战高手班 6

课时:3天 技术点:40项 测验:1次 学习方式:线下面授

学习目标

1.掌握BI报表开发需求分析| 2.掌握BI报表工具| 3.掌握FineReport报表

主讲内容

1. BI报表开发掌握BI报表开发常见流程和工具,完成电商行业BI报表开发

01_BI报表开发需求分析| 02_BI报表工具| 03_FineReport报表入门| 04_泛电商行业五大主题的实现

-

Spark技术栈高手班 7

课时:10天 技术点:110项 测验:1次 学习方式:线下面授

学习目标

1.掌握Spark的RDD、DAG、CheckPoint等设计思想| 2.掌握SparkSQL结构化数据处理,Spark On Hive| 3.掌握Structured Streaming整合多数据源完成实时数据处理| 4.具备Spark全栈开发能力,满足大数据行业多场景统一技术栈的数据开发,提供就业核心竞争力

主讲内容

1. Spark基础本阶段学习Spark环境搭建及以下知识点:

01_Spark基础环境搭建| 02_Spark的Standalone环境搭建| 03_Spark的StandaloneHA搭建| 04_SparkOnYarn环境搭建

2. Spark Core整个Spark框架核心部分,掌握框架内部设计思想,数据流转步骤,是学习Spark的基础模块,包含了以下技术点:

01_Spark架构和原理(运行机制、Driver和Executor、spark任务提交流程)| 02_RDD开发和原理(Partition、Task、RDD的依赖关系、RDD的容错机制、RDD的存储级别、RDD的缓存机制)广播变量 | 03_DAG原理(DAG思想、DAG的生成、DAG的处理过程)

3. Spark SQL学习Spark框架的SQL操作,Spark与Hive等外部数据源的整合操作,包含了以下技术点:

01_Spark SQL架构和原理| 02_DataFrame、DataSet DSL和SQL开发| 03_Spark多数据源整合(txt、CSV、Json、parquet、JDBC、Hive)| 04_Spark SQL执行计划原理| 05_Spark SQL性能调优

4. Kafka消息队列主要讲解消息中间件核心知识,包括知识点如下:

01_Kafka原理及架构分析| 02_分布式实时计算架构和思想| 03_陌陌社交场景实战| 04_社交大数据架构剖析

5. StructedStreaming主要讲解Spark实时计算组件,整合Kafka+StructedStreaming,包括知识点如下:

01_流式计算基础概念| 02_Structured Streaming编程模型| 03_Structured Streaming整合Kafka| 04_Structured Streaming实时数据处理与统计分析

6. Spark案例实战践行场景式教学,运用了Spark阶段知识点,使用Lambda加解决数据分析的应用,包含了以下技术点:

Spark案例实战|Kafka和Structed Streaming

-

用户画像解决方案高手班 8

课时:10天技术点:90项测验:0次学习方式:线下面授

学习目标

1. 掌握SparkSQL整合ES自定义数据源| 2. 掌握用户画像构建流程| 3. 掌握用户画像标签构建规则| 4. 掌握用户画像规则类标签构建| 5. 掌握用户画像统计类标签构建

项目提供了全行业用户画像解决方案, 使用SparkSQL+ES+DS构建企业级用户画像,通过SparkSQL+MySQL构建通用行业用户画像标签体系。

进入项目体验主讲解决方案

用户画像解决方案,主要针对于泛电商或保险行业完成用户标签设计,提供了全行业解决方案,课程采用由浅入深,层层递进的讲解方式, 让你轻松掌握企业级用户画像的使用, 使用SparkSQL+ES+DS构建企业级用户画像。

主讲知识点

01_SparkSQL整合ES自定义数据源| 02_DS任务界面化调度| 03_用户画像标签构建规则| 04_用户画像规则类标签构建| 05_用户画像统计类标签构建

-

PB级内存计算项目实战高手班 9

课时:3天技术点:88项测验:0次学习方式:线下面授

学习目标

1.掌握保险行业数据分析流程| 2.掌握保费计算流程| 3.掌握DS调度流程| 4.掌握UDAF使用场景

保险精算项目需要计算海量明细保单数据,以便生成财务报表。项目使用SparkSQL来计算,时效变快,增强保险公司的商业信誉。项目将多部门的业务数据库同步到hive数据集市,使用SparkSQL加载源数据表(保单表12亿保单,客户表8千万客户等),计算保单的保费、现金价值、准备金等明细,提供给财务部门收费或支出,对保单汇总计算(业务发展类指标,成本费用类指标等),并向业务人员做数据展示。

进入项目体验主讲解决方案

项目核心架构和业务流程、Hive数仓建模 、Sqoop数据同步开发 DolphinScheduler任务调度、使用lag,sum等窗口函数 、使用UDAF函数计算有效保单数字段、计算现金价值、计算和准备金、分区表的使用 、指标汇总计算 、Shuffle优化。

主讲知识点

基于Spark轻松应对保险复杂的迭代计算

-

基于AI大模型数据开发项目实战高手班 10

课时:2天 技术点:30项 测验:1次 学习方式:线下面授

学习目标

1.完成ChatGPT基础使用| 2.基于ChatGPT可以完成改Bug,写注释,生成代码等常见编程任务| 3.能够基于合理的Prompts提示词进行提问,助力提升编程效率

主讲内容

1. AI大模型提升数据开发效率掌握基于AI大模型完成大数据开发任务,助力开发效率提升

01_ChatGPT生成代码| 02_ChatGPT改Bug| 03_基于AI大模型的出行大数据平台数仓搭建| 04_基于AI大模型指标开发

-

面试加强高手班 11

课时:4天 技术点:40项 测验:0次 学习方式:线下面授

学习目标

1.强化面试就业核心面试题| 2.梳理大数据架构及解决方案| 3.剖析多行业大数据架构

主讲内容

1. SQL实战解决Python大数据常见的SQL面试题,包含了以下技术点:

01_面试题必备SQL实战| 02_SQL优化加强

2. Hive数据分析与面试题加强解决Hive数据分析开发必备面试题,包含了以下技术点:

01_Hive基础| 02_Hive拉链表| 03_Hive数据仓库构建示例| 04_Hive面试题

3. Spark数据分析与面试题加强解决Spark开发必备面试题,包含了以下技术点:

01_Spark基础| 02_Spark离线分析| 04_Spark面试题

4. 大数据多行业架构剖析解决多行业多场景大数据架构设计,具备举一反三设计大数据架构体系能来,包含了以下技术点:

01_数据分析流程| 02_大数据架构剖析| 03_多行业大数据架构设计| 04_大数据存储,调度等解决方案

-

阿里云实时计算Flink全栈开发高手班 12

课时:5天 技术点:80项 测验:1次 学习方式:线下面授

学习目标

1.掌握基于阿里云Flink进行实时和离线数据处理、分析| 2.掌握基于阿里云Flink的多流并行处理技术| 3.掌握FlinkCDC多数据源采集技术

主讲内容

1. 阿里云Flink入门掌握国内最火的阿里云Flink技术,完成SQL、Python等作业提交。

01_阿里云账号角色授权| 02_开通Flink全托管| 03_Flink SQL作业快速入门| 04_Flink JAR作业快速入门| 05_Flink Python作业快速入门| 06_数据库实时入仓快速入门| 07_日志实时入仓快速入门

2. Flink SQL掌握FlinkSQL流批一体开发流程,集成Flink核心窗口、水印、状态管理等高级功能,助力高效开发。

01_Flink SQL开发| 02_Hive + Flink SQL| 03_Watermark| 04_Checkpoint| 05_任务调度与负载均衡| 06_状态管理| 07_Flink性能监控| 08_Flink调优| 09_Flink SQL执行计划

3. Flink作业开发掌握Flink作业开发流程,完成不同方式的作业开发和调试。

01_作业开发| 02_SQL作业开发| 03_JAR作业开发| 04_Python作业开发| 05_作业调试| 06_模板中心| 07_管理自定义连接器| 08_管理自定义函数(UDF)

4. 阿里云Flink运维掌握Flink运维流程,针对不同场景通过不同解决方案,达到高效运维使用云平台。

01_权限管理| 02_RAM用户授权| 03_作业操作账号授权| 04_作业启动| 05_作业停止| 06_管理作业版本| 07_修改作业配置| 08_查看作业详情| 09_查看与修改作业运行状态| 10_调优诊断| 11_查看作业性能| 12_作业智能诊断| 13_配置自动调优| 14_高性能Flink SQL优化技巧| 15_作业状态管理| 16_企业级状态后端存储介绍| 17_作业状态集管理| 18_Flink State兼容性参考

-

阿里云实时计算项目高手班 13

课时:5天技术点:80项测验:0次学习方式:线下面授

学习目标

1.基于阿里云Flink + Kafka + Paimon 湖仓一体技术架构| 2.基于FlinkCDC完成MySQL等数据源的数据采集| 3.FlinkSQL流批一体架构实现实时数据计算| 4.使用Starrocks进行海量多维分析| 5.掌握数据报表分析| 6.掌握业务数据实时大屏场景实现

本项目是基于某物流公司业务研发的智慧物流大数据平台,公司业务网点覆盖各地,大规模的客户群体,日订单达1000W,平台对千亿级数据进行整合、分析、处理,保障业务的顺利进行。

进入项目体验主讲解决方案

采集超过千万条在线视频的数据,实时高性能海量数据分析与存储业务数据实时大屏场景实现。

主讲知识点

基于Flink + Kafka + Paimon 湖仓一体技术架构,实现在线视频行业大规模流数据处理和实时分析。本项目依托 阿里云 Flink 流处理计算引擎, 通过 FlinkCDC 实时采集 RDS MySQL 数据库数据,实现数据采集的断点续传,使用Kafka 作为实时数仓,使用 Paimon 实现数据的持久化和Flink 批处理,实现计算的流批一体,数据存储的湖仓一体,采用StarRocks对接DataV完成实时业务大屏展示。

-

亚秒级实时进阶课进阶班 1

课时:60天 技术点:1000项 测验:0次 学习方式:线上学习

学习目标

1.线上3个月进阶大数据实时开发,多行业大数据项目助力企业数字人才精英| 2.皆在成就实时开发工程师,大数据架构师等,帮助学员成为站在金字塔顶端的实时工程师

主讲内容

1. 大数据Java语言大数据生态多语言开发,为进阶实时数据开发奠定基础

01_编程基础| 02_面向对象| 03_常用类| 04_集合操作| 05_IO操作| 06_Java基础增强| 07_JDBC| 08_Maven| 09_爬虫案例

2. 数据采集掌握实时计算中组件,数据开发工程师重要技能

01_Flume| 02_DataX| 03_实时采集

3. NoSQL&消息中心分布式存储和消息队列专项课,从原理到源码,助力多场景存储技术架构选型,升值加薪必备技能。

01_分布式缓存Redis| 02_消息队列Kafka| 03_Hbase| 04_ELK技术栈| 05_消息队列Pulsar

4. 实时OLAP框架掌握实时OLAP框架,数据开发工程师重要技能。

01_实时OLAP框架ClickHouse| 02_实时OLAP框架Doris

5. 数据湖开发数据湖技术专题课程,完成湖仓一体架构进阶。

01_Hudi 基础入门篇| 02_Hudi 应用进阶篇| 03_Hudi 实战案例篇

6. Flink技术栈Apache Flink作为当下流行的实时技术,深度剖析底层原理,实现高级实时开发工程师进阶。

01_Flink基础| 02_Flink DataStream的使用| 03_Kafka + Flink| 04_Flink SQL开发| 05_Hive + Flink SQL| 06_Flink CDC| 07_Flink CEP /Flink CEP SQL| 08_Watermark| 09_Checkpoint| 10_任务调度与负载均衡| 11_状态管理| 12_Flink性能监控

7. FlinkSQL原理到精通全网流批一体架构FlinkSQL,进阶技术+业务专家。

01_Flink SQL开发| 02_Hive + Flink SQL| 03_Flink性能监控| 04_Flink调优| 05_Flink SQL执行计划| 06_FlinkSQL案例实战

8. 星途车联网实时项目掌握车联网大数据实时业务场景开发,助力物联网行业高薪挑战。

01_Hive| 02_HBase| 03_HDFS数据存储| 04_Kafka数据传输| 05_Flink全栈数据处理| 06_Nginx做反向代理| 07_LSV和Keepalived负载均衡和高可用

9. 今日指数证券实时项目掌握金融业务数据实时场景实,助力金融行业高薪挑战。

01_Druid| 02_HBase| 03_HDFS数据存储| 04_Kafka数据传输| 05_Flink全栈数据处理| 06_Kylin 多维OLAP分析| 07_Redis高速缓存

10. 基于DataWorks全链路数据开发掌握智慧出行实时项目业务数据实时场景,覆盖全网所有DataWorks平台大数据。

01_智慧出行实时项目业务数据实时场景异构数据源采集| 02_基于DataWorks的大数据平台设计| 03_出行行业可视化完整架构,涵盖全生命周期项目

11. 湖仓一体化解决方案掌握基于湖仓一体的在线视频实时分析项目,助力大数据新技术企业应用。

01_湖仓一体完整解决方案| 02_基于Flink的在线视频数据处理与分析| 03_基于Hidi的在线视频数据数据湖构建

12. Flink源码剖析全网Flink源码课程大全,从原理到源码,深挖技术底层,助力Flink性能调优,大数据架构师必备技能。

01_Apache Flink设计理念与基本架构| 02_Flink DataStream的设计与实现源码分析| 03_Flink 运行时的核心原理与实现| 04_Flink 任务提交与执行| 05_状态管理与容错| 06_网络通信| 07_内存管理

13. Flink二次开发掌握Flink二次开发流程,个性化解决企业大数据平台技术选型,助力在职的你持续高薪,大数据架构师必备技能。

01_基于PyFlink的PR提交| 02_Flink的源码二次开发流程| 03_Flink的源码二次开发需求分析| 04_Flink的源码二次开发实现过程| 05_PyFlink相关功能二次开发

-

Python+大数据开发 V版本课程说明

课程名称:主要针对:主要使用开发工具:

课程介绍

9970元/月平均薪资

15900元/月最高薪资

100%就业率

58人月薪过万

- 姓名

- 性别

- 就业时间

- 就职城市

- 就职企业

- 薪资

- 福利待遇

- 姓名

- 培训前岗位

- 培训前薪资

- 培训后薪资

- 入职时间

- 入职公司

- 就职城市

*学员就业信息统计数据为数据库中实时调取的真实相关数据,非广告宣传